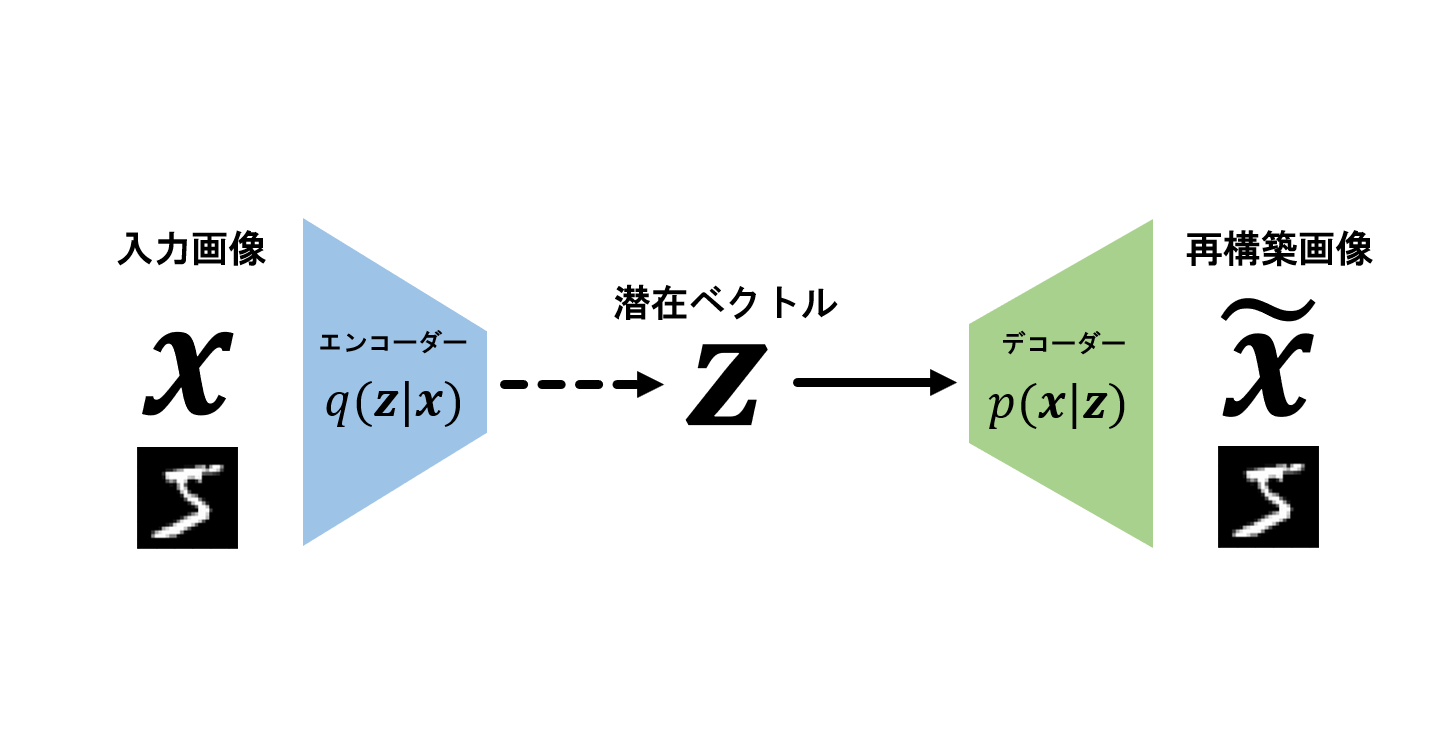

背景

VAEGANモデルの論文とコードを元に、自作したコードを使用してpytorchで学習してたら突然こんなエラーが出ました…何これ?

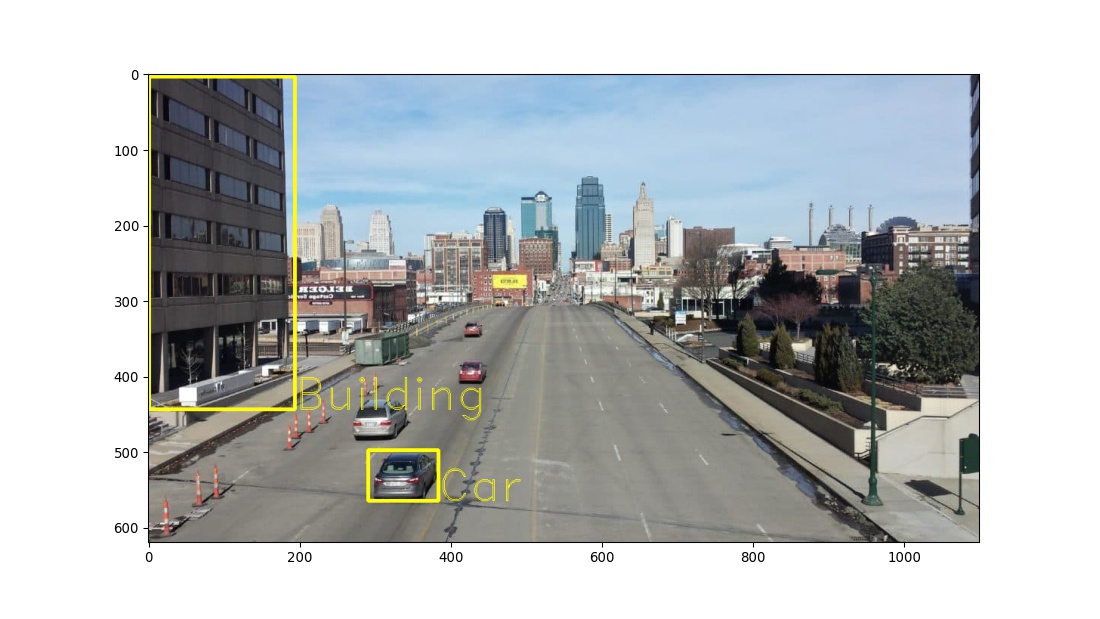

ログの確認

ちょっとログを確認すると、Encoder の損失が突然指数関数的に増加してます。ここがエラーの原因ぽいですね…。

私の場合は Encoder の分散が大きくなりすぎて学習が不安定になったのではないかと思われます。

(Decoder の Loss が負なのはまた別の問題なのでここでは説明を割愛します)

エラーの解決方法

職場の人たちの知恵に頼ったところ「Encoder がはちゃめちゃに不安定になっているのは、学習率が大きすぎる所為ではないか」との意見をいただきました。

実際に学習率を10分の1に下げたところこのエラーが出てくることも Encoder の損失が突然大きくなることも無くなり解決しました。